在隨行付的微服務架構演進中,服務間的數據同步與一致性保障一直是系統設計的核心挑戰之一。為解決跨服務、跨數據庫的數據實時同步與異構數據源整合問題,隨行付自主研發了數據同步中間件——Porter。本文將深入探討Porter的設計理念、核心架構及其在軟件開發中的實踐應用。

一、Porter的誕生背景與設計目標

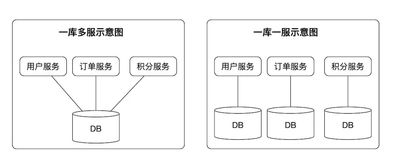

隨著業務模塊的不斷拆分與獨立部署,各微服務擁有獨立的數據庫,形成了數據孤島。傳統的數據抽取、轉換、加載(ETL)工具在實時性、靈活性和運維復雜度上難以滿足高并發、低延遲的金融支付場景。Porter應運而生,其核心設計目標定位于:實現跨數據源的近實時數據同步、保障數據最終一致性、降低業務系統耦合度,并提供高可用、可擴展的運維能力。

二、核心架構與工作原理

Porter采用基于日志增量捕獲(CDC)與消息隊列的架構模式,主要由三個核心組件構成:

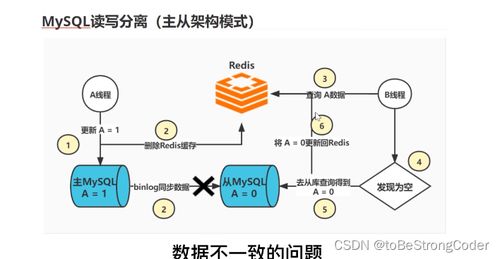

- 采集器(Collector):以無侵入方式監聽源數據庫(如MySQL)的二進制日志(Binlog),解析并過濾出變更事件,將其轉化為統一格式的消息。

- 消息隊列(MQ):作為可靠的中轉通道,接收采集器發布的事件消息,起到緩沖、解耦和保證消息有序性的作用。

- 執行器(Executor):訂閱消息隊列中的事件,根據預定義的規則進行數據轉換、映射,并最終寫入目標數據存儲(可以是另一個數據庫、緩存或數據倉庫)。

其工作流程可簡述為:源庫數據變更 → Collector捕獲并發布消息至MQ → Executor消費消息并應用至目標庫。這種設計確保了數據同步的異步性與松耦合。

三、關鍵特性與技術創新

- 多模式同步:支持全量同步、增量同步及“全量+增量”混合同步,滿足初始化、數據遷移與持續同步等多種場景。

- 靈活的數據過濾與轉換:提供基于SQL或配置化的規則,支持按表、按字段、按操作類型(增刪改)進行過濾,并能進行簡單的數據清洗與格式轉換。

- 高可用與容錯:采集器與執行器均支持分布式部署與水平擴展,通過 checkpoint 機制記錄同步位點,確保故障恢復后數據不丟失、不重復。

- 監控與運維:提供豐富的管理控制臺,實時監控同步延遲、數據流量、組件健康狀態,并具備告警與可視化鏈路追蹤能力。

四、在軟件開發中的實踐應用

在隨行付的支付、風控、賬務等核心系統中,Porter扮演著關鍵角色:

- 讀寫分離與緩存更新:將主庫的實時變更同步至只讀從庫或Redis緩存,提升查詢性能。

- 數據倉庫(ODS)構建:將多個業務庫的訂單、交易數據實時匯聚至數據倉庫,支撐實時分析與報表。

- 跨微服務數據共享:在保證服務自治的前提下,將用戶中心的核心數據變更同步至其他業務庫,避免頻繁的跨服務接口調用。

- 數據備份與容災:實現異地、異數據庫的實時數據備份,為災難恢復提供支持。

五、與展望

Porter作為隨行付微服務生態的重要基礎設施,成功解決了分布式環境下的數據流動難題,提升了研發效率與系統可靠性。其設計充分體現了關注點分離、最終一致性與可觀測性等現代軟件工程原則。Porter將繼續向智能化運維、更豐富的數據源/目標支持(如MongoDB, PostgreSQL)、以及流式數據處理能力等方向演進,以更好地支撐隨行付業務的快速發展。

通過Porter的實踐,隨行付團隊不僅打造了一個高效的數據同步工具,更深化了對微服務架構下數據治理的理解,為構建穩定、敏捷的金融科技系統奠定了堅實的數據基石。